前回

下記をいつでも開けるようにしてください。

- チャンネル処理モード

- トランジェントについて

- MS処理

- Ozoneで考えるMS処理の向き合い方

- サンプルレートとビットレート

- ナイキスト周波数

- 32bit float

- エクセルの高速フーリエ変換計算を用いて、エイリアシングとEQ作業を体験

- 手作業EQ

チャンネル処理モード

後回しにしていたチャンネル処理モードについてまとめます。

Stereo: デフォルト処理モード。

Mid/Side : このモードにしたとき、入力信号をMid/Side計算で適用し、Mid/Sideそれぞれのチャンネルで個別処理できるようになります。最終的にモジュール出力からステレオ信号に戻されます。

Left/Right : 左右チャンネル独立処理。モジュールの出力でステレオに「合計」されます。

Transient/Sustain : モジュールに入力信号からトランジェント成分を分離し、トランジェントとサスティンを個別処理。モジュール出力で再び全体にミックスされます。

下記はトランジェントサスティンモードの紹介です。

モジュールの中で、それぞれの成分に分離して整形し、その整形した成分を元のミックスに配合していく、という感じです。

元音+加工音混ぜ混ぜ構造。

カレーで言えば、中に入れたじゃがいもだけ検出し、少し歯応えがあるように硬くした後、じゃがいもだけ戻す、みたいな神機能です。

一方でミックスやアレンジ段階で、自然なトランジェント自体を積極的に変化させていくことで遠近感が出たり、lo-Fi感が出していたりします。

マスタリングにおけるトランジェントの加工は、元曲に施されたトランジェントの意図をしっかり掴んだ上で行うのは云うまでもなく。

データもらった時にすぐその方向性の相談に気を遣えるくらいじゃないとダメなんでしょうね。

トランジェントについて

オーディオにおけるトランジェントは、「電圧または負荷の突然の変化により回路内で発生する一時的な発振」と定義されます。

引用は下記記事より。

さらにトランジェントモードを使って、スネアのプーーん!という共鳴部分だけを取り除く、という技を披露してくれます。幾つもあるスネアのマイクトラックの一つ一つEQをいじって、みたいにしないで、これだけで削除できる凄み。動画の中でトランジェントとサスティンを分けてsolo聴きできるところとか驚きます笑

ダイナミクスなどだとアタックとリリースをmsで調整する分、適切なトランジェントを作ることもできます。しかしピンポイントで周波数を指定してその部分の音のエネルギーを持ち上げたいのなら、EQのトランジェントモードが便利です。このとき、アタックやリリースは指定できないので、別途ダイナミクスなどで指定する必要があるかもしれません。

しかしEQで指定した帯域をあげる時は、適切に遅延なく上げてくれる仕様になっているのでオートメーションで楽だと感じる方もいるでしょう。

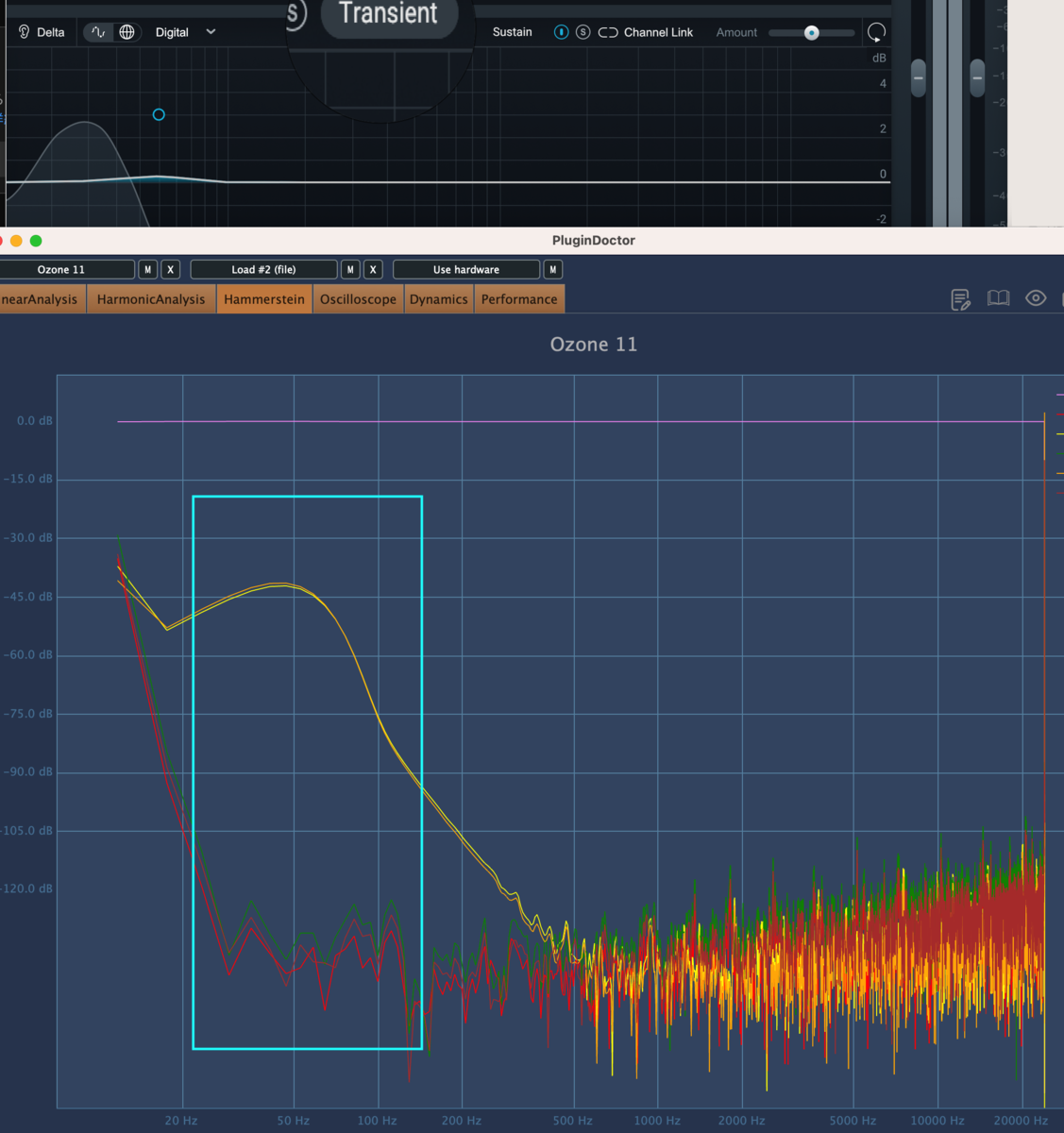

ただし、トランジェントモードはいじる帯域に応じて独特のノイズが増えます。このようにしてトランジェントのエネルギー(音量等)を持ち上げているんですね。

当然ステレオモードでは出ません。

ただこれらのノイズを巧みに組み合わせて音量を大きくして、聴きやすいバランスにしていくので、ノイズが悪いわけではありません。

「Ozoneだめ」みたいに感じるのは、さまざまな方法を組み合わせてよりできる高いミキシング知識がないと問題解決策に辿りゆけないため、単発に挿していじるだけ、みたいなプラグインと同じようにはいかないだけです。Ozoneでも追い込む方法はいくらでもあると思うので、オールインワンプラグインがお好きなかたは、さまざまなモジュールの組み合わせを深く深く潜り込んで見つけてみた方が近道と感じます。

またそこで感じた問題はどんどんiZotope側にフィードバックしていくと、プラグインは結構自分が思うように進化してくれます。そこがうまくいかない(メーカーとウマが合わない)なら他に乗り換えていいと思います。

MS処理

こちらも7:00ぐらいから聞いていただければMS処理について教えていただけます。

・モノラルファイルをステレオ化してもSide成分はないから(Mid成分しかない)そこでMS処理をしても意味がない

・MS処理は音楽を変える魔法の行為ではなく、ミックスの問題点としてMS処理が必要(他の解決法で代替もできる=人のやり方それぞれ)と感じたから行うだけで、それはEQ処理などと等しい作業。

っていう話とか本当に初心者は分からないので、こうやって当たり前のことを教えていただけるのはありがたいです。

L+R=Mid成分

L-R=Side成分

私たちが「ミッド」と呼ぶものは、実際には左チャンネルと右チャンネルの合計です。これにより、両側で同じものが強調され、異なるものは強調されなくなります。同様の素材が左チャンネルと右チャンネルの両方で強調されるため、結果として得られるオーディオはモノラルとして認識されます。「サイド」もモノラル信号です。左側からのすべての情報から右側からの情報を差し引いたもの(左側 + 位相反転された右側)で構成されます。

(中略)

実際には、これは、片側に強くパンされた楽器であっても、実際には、Mid/Side 処理を通じて M 信号と S 信号の両方に影響を受けることを意味します。

当たり前なのですが、和と差の計算によって導き出したデータに特別な処理をしてまた合算するので、mid/side成分を単純に広げたり、EQ/コンプ処理したとき、sideに残った分にFXがかかり、midに残った成分にはFXがかからない、ということが起こります。結果として広がってはいるけど位相がずれてダイナミクスがおかしくなった、質感が変わったなんてことが起きます。

それよりもミックスに戻ってまずパンニング、音量のバランスをしっかりまとめましょう、となります。MS処理はよほどバランスの悪い音源、バランスの悪い録音に対して致し方なく行うことで改善が見込まれる携帯消化器みたいな緊急消化処置、とまずは思っておけば「マスタリングではMS処理は必須」などと思わなくて済むと思います。

やってみればわかりますが、これは実はマスタリング専門職の方が最高級のスタジオで聞きながら行うべき作業なのではないか?と感じます。

耳に感じるほどまで変えたらやりすぎだし、全く感じなければやってる意味がありません。データ上の変化があって、聞こえる音の微細な違いの程度が識別できないと、MS処理の適切な程度を割合を当てがうのは難しいのではないでしょうか?

ただ「一流しかできないオリンピックの技」では商品にならないので、「だれでもできますよ?」という売り文句になっているだけでは??ぐらいの恐怖を感じます笑。

慎重にどの成分をどう考え、扱っていくか。下記ジョナサンに教えてもらいましょう。

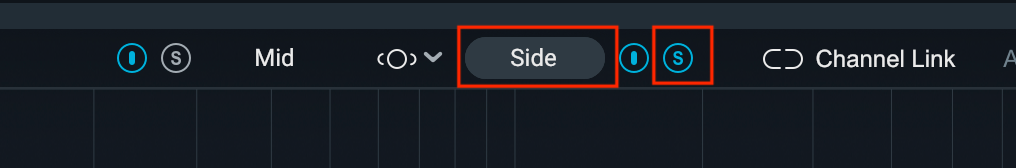

OzoneEQの作業でMid成分でLowの成分をさげ、Side成分でhighの成分をあげた場合

上記のように別々の画面で作業でき、それらがミックスにamount量で混ぜられます。

Channel Linkを入れた後作業した分の作業はMS双方に反映します。

素人がこんな処理をマスタリングでしたら話がややこしくなる元です。

それよりもOzoneにはImagerがあるので、最初はこれでステレオ幅を広げた方が位相を崩さず聞かせたい音を聴かせられるかもしれません(imagerも極端だと位相ズレや余計なノイズが積もる原因になりますが)。

この素人は何もやんな!的な感じ笑。これまで何十万も払ってマスタリングエンジニアにやってもらっていた作業を何で自分ができると思った?

また一度ステレオ設定で行った作業はモードを変えるとそれぞれのMSモードやLRモードトランジェントモードにチャンネル単位で置き換わってしまうので、ステレオ処理でEQを使い、MS処理でもEQを使う、とかいう場合は、EQを二つ挿すしかありません(わかってやらないと位相めちゃくちゃになりそうですが、多分一般には聞き取れないレベルでの劣化なので、十分なスピーカー環境、視聴環境があるレベルの方が行う作業だと思います=ベッドルームプロデューサーは慎重に)。

Iボタンを押せばその処理が可能になり(電源)、sボタン(solo)で変化認識されている音を聞くことができます。

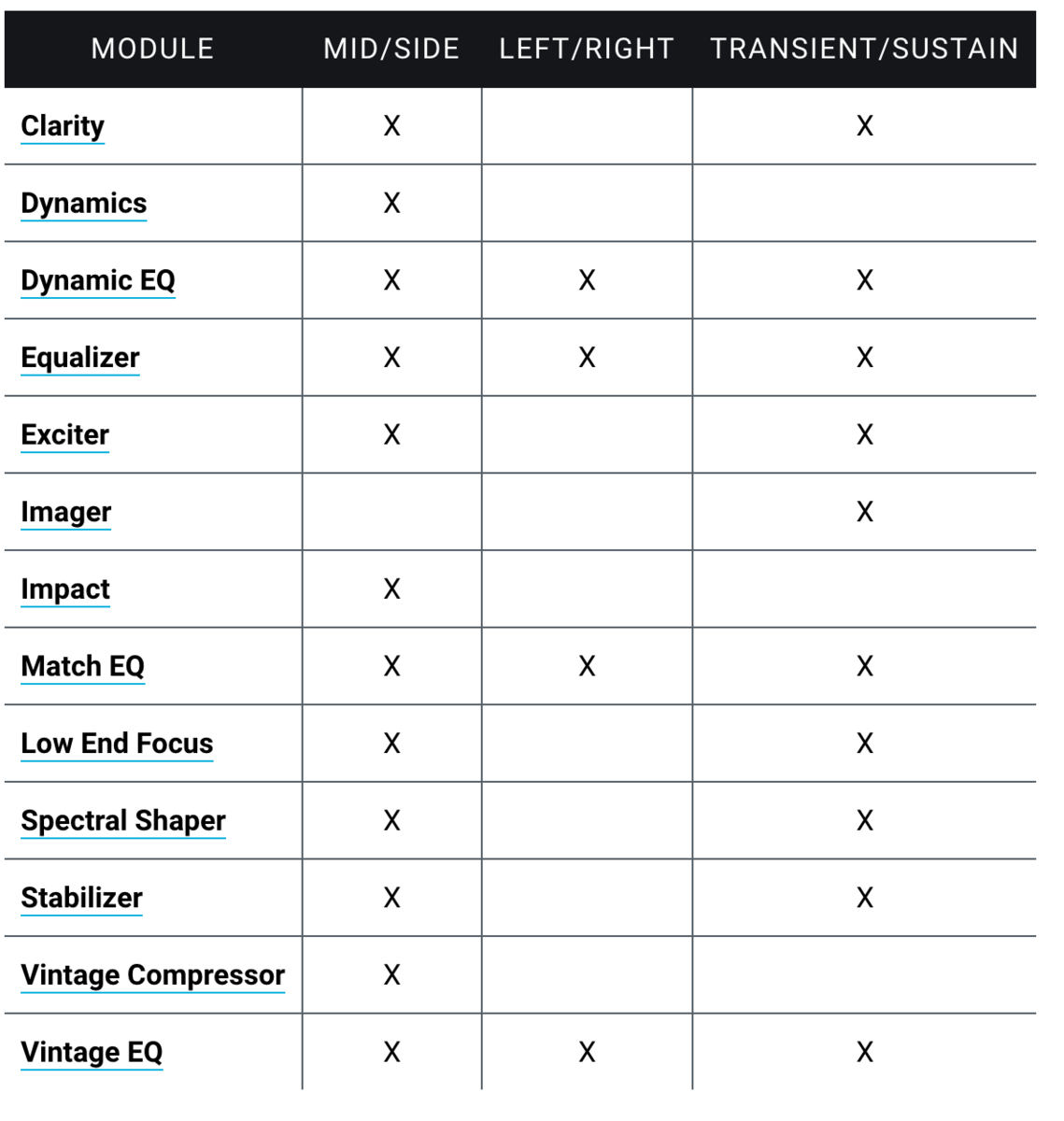

下記は説明書からの引用です。それぞれのモジュールで扱える処理一覧です。

それぞれの処理にそれぞれの結果が待っているので、どこをどうやったら適切か、を学ぶだけでも数年かかりそうです。

Ozoneで考えるMS処理の向き合い方

ガチ寄りのガチな人には御鼻で笑われそうですが、OzoneにおけるMSデータの扱いを考えてみましょう。

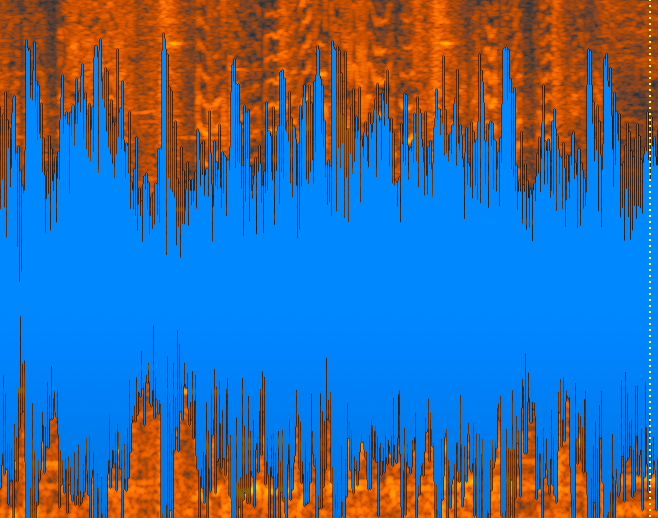

例えば、下記のようなドラムパターンで考えます。

この音源のside成分をバウンスしてみました。これがLとRの位相差です。モノラル スピーカーだと聞こえないかも。イヤホンで。

この時EQでsideだけソロにしています。

sideで鳴っている音も広い帯域が鳴ってます。

これをimagerのpolar levelなどで見ると「side」の意味がわかります。

side成分はガチで左右に振り切った音の成分として検出されます。このLRの音の状況によって、センターで聞こえる感じの音もあるので、真ん中に聞こえたりします。sideと言われる所以です。

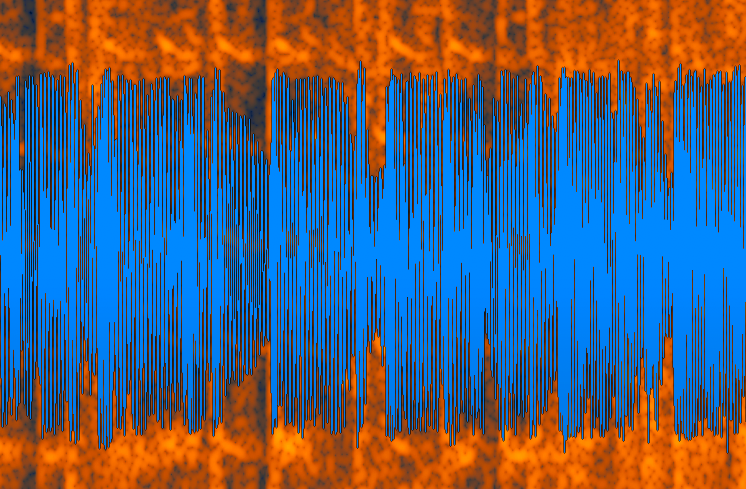

逆にmidは下記になります。

mid成分も同様に広い帯域に鳴っています。

下記をみればその名の通り、midにだけ鳴っています。LとRのデータのそれぞれで全く同じ音(波形)のデータだけを鳴らせているのでセンターになっていて当然ですね。

まとめると、

mid成分=どセンターで鳴ってる音

side成分=どサイドで鳴ってる音

とまずは考えてミックスしてみてはいかがでしょうか。それ聞き分けられるのってミックスやってる人だけじゃない?笑

耳で区別する良い方法があります。

2mix

mid

mid成分をソロ聴きしたり消したりしてみてください。これで2mixとmid成分を比較しながら聞けます。

若干side成分が欠けていたり追加されたりするのを感じると思います。

当然2mixの方がサウンドが豊かに聞こえますね。よほど変なデータでない限り、そのゆたかな2mixのわずかなside成分をいじってどれだけ良さを追い込めるでしょうか??

また、midデータがうるさすぎるなら、MS処理ではなくてEQやコンプをかけた方が普通に良い、という選択肢もあろうかと思います。わずかなside成分を残してmidを上げ下げすることでの位相のぶれと、EQによる位相のぶれをOzoneは視覚的にも把握できるので、比べることもできます。

または結果を比べないとわからないような耳のレベルならMSは使うな、みたいなtipsでも最初はスッキリして良いかと。

クライアントの求める2mixの質感を変えてしまうことにつながらないか、的なことはいつも感じます。人が考える良いミックスはその人の聞いてきた音楽に依存します。この人の作る音が好きだからこの人にマスタリングを任せる、という状況以外、私がやっても「なんか違うんですが」って言われそう笑

sideをソロ聴きした時、上記あたりがボワボワ、キンキンいっていたから、そこだけ少し削りたいみたいな欲求は確かに起きますが、2mixで合わせて聴くと気にならない、みたいな状況も多いです。

簡単に作業後「スッキリしたなぁ」と思ったらやりすぎです笑。それは「前と変わった感じになっただけ」で、良い音になっているかどうか???

丁寧にやるなら、OzoneのAIマスターアシスタントが自動計算で弾き出す結果でもしMS処理が提案された時、その数値を眺めながらMSが行う結果効果を分析する、というところから勉強してみることをお勧めします。

またそのほかの同様なMS処理可能なプラグインとOzoneの併用もあまりお勧めしません。

多段掛けでやり切った感覚えたあと、じっくり寝室で聞いたら、何もしない提出時の元曲の方がよかった、みたいなことも...笑

・Impact、spectral saper、Imager、EQモジュールでのMS処理より、ステレオ処理の方がガッツリきく。

・clarityはあげることでこもる、小さくなる可能性がある

などのご自身での使用感をあらかじめまとめておくといざという時使いやすいと思います。

ではマスターアシスタントをサポートに使ってマスタリングを進めていくシミュレーション動画を見てください。Ozone9なので少し勝手が違いますが、やるべきことは同じです。青木氏が言うようなイメージ、音の変化をみなさんの環境で捉えられるでしょうか??

基本の確認。

サンプルレートとビットレート

ビット深度 (bit/sample) x サンプルレート (sample/s)=ビットレート(bit/s) (データ転送レート)

16bit x 44100Hz x 2ch(stereo) = 1411200b/s = 1411.2Kb/s

16bit x 48000Hz x 2ch(stereo) = 1536000b/s = 1536Kb/s

24bit x 44100Hz x 2ch(stereo) = 2116800b/s = 2116.8Kb/s

24bit x 48000Hz x 2ch(stereo) = 2304000b/s = 2304Kb/s

という計算内容が理解できれば これらの数値の意味もだいたい理解できたことになると思います。モノラルなら1chなのでこれらの値の答えの半分の値です。

他でこういう基本を書いたことがないので、ここにまとめておきます。

DPのトランスポーターの横にあるやつです。

48Kがサンプリングレートです。

1秒間の音声を48000の単位に区切ってその都度データ化しています。ここでのHzは音声ではありません。1周期サンプリングする、という意味です。

単位が色々似ているので紛らわしいですね。「48000回」とかにしてくれればいいんですが笑。

48KHzでサンプリングすると1単位が0.020833...ミリ秒です。この記事でも出てきたオーディオ変換した時のTrue peakはこの約0.021msの間に起きるピークの可能性を計算してるんですね。

人間は左右の音のずれを聞き取るのに0.01ミリ秒(10マイクロ秒)でも聞き分けられるそうです。

音楽制作をやっているとミリ秒を感じるとか普通になってきます。

サンプリングは録音しているのではなく、電圧差などのデジタル数値で測定できる値を測定しています。

なんで電圧?と思うかもしれません。少し脇道に逸れます。電圧とオーディオ信号って音楽家はなかなか最初は関連付けられないと思います。

電圧とは2地点の電位差のことです。水が流れる勢いに例えたりします。大きく振動するとより強く電気が流れ、小さく振動すると、より弱い勢いで電流が流れます。その勢いが「電圧」と思ってください。電気が流れた量ではなく、流れる強さで記録するんです。電圧は振動の連続変化を記録しやすい存在だからだそうです。

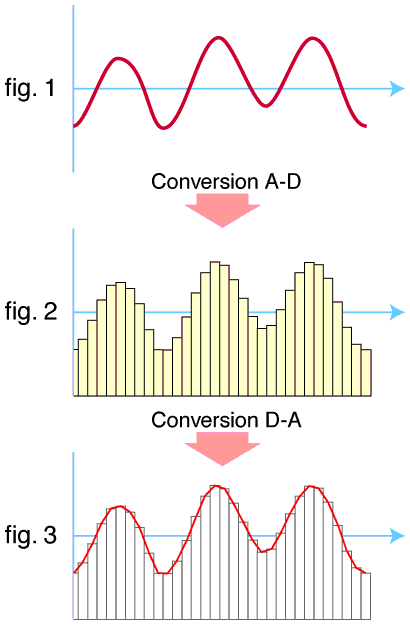

例えばあなたが「あ!」と叫んだ声を録音してDAWに取り込もうとするとき、A/D変換という作業が必要です。アナログの振動現象を数値化できる値(デジタル)に変換する処理です。

声を出すと空気が振動しますが、この振動の細かい時間的変化を正確に捉え、その振動の大きさに応じて、細かい電気信号の電圧値の変化として記録します。振動の強さで発信される電圧が変わるような仕組みで録音されます。

これによって空気の振動の強さを細かい電圧の数値に変えることで、デジタルで表現できる値にするんですね。空気の振動で声の感じとか、倍音の感じとか、正確に記録できる仕組みってすごいですね。

細かく振動する現象を数値記録する仕組みとして、下記動画などでコイルと磁石の前後振動でイメージしてください。これもエジソンが日常空間の空気体の振動を蝋に削りこんで刻みつけてた歴史に始まります。

振動を電圧に変える、というのが何となくわかったでしょうか?

ここでも「電磁誘導」という原理がわからないとピンとこないかもしれません。

電磁誘導は、現在私たちの電気を作っている発電所の仕組みとおなじです。

コイルの近くで磁石を動かすと電気が作れるんです。この振動の向きを音声の振動と呼応させることで、音の振動が電気になるんですね。水力発電所の仕組みの動画とか見てみてください。ダムの水で発電機を回転させて、同じように電気を作ってます。すごくアナログでもあります。義務教育で学んだはずですが、まさか音楽制作に関わってくるなんて思ってもいません。

でも動物の耳の鼓膜も振動を電気信号に変えて処理しています。電気って不思議です。

あとはその振動をデジタルのサンプリングで記録する精密さの度合いです。

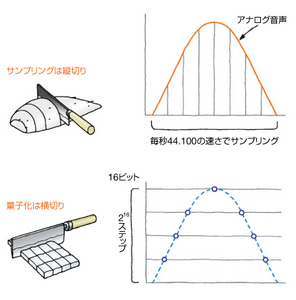

林先生のページから拝借します。

あなたがピアノを弾いて音になって録音された音響は音の強さや長さ、高さなどのデータが様々記録されます。それをデジタルデータ0と1で全て表すために、1秒間を例えば48000回標本化します。

縦で時間を区切ることが標本化。

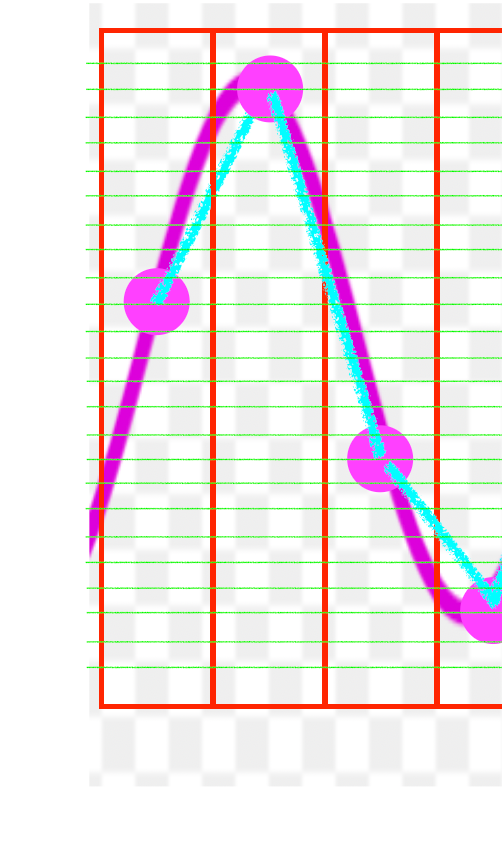

そして横で区切るのが量子化/ビット深度です。

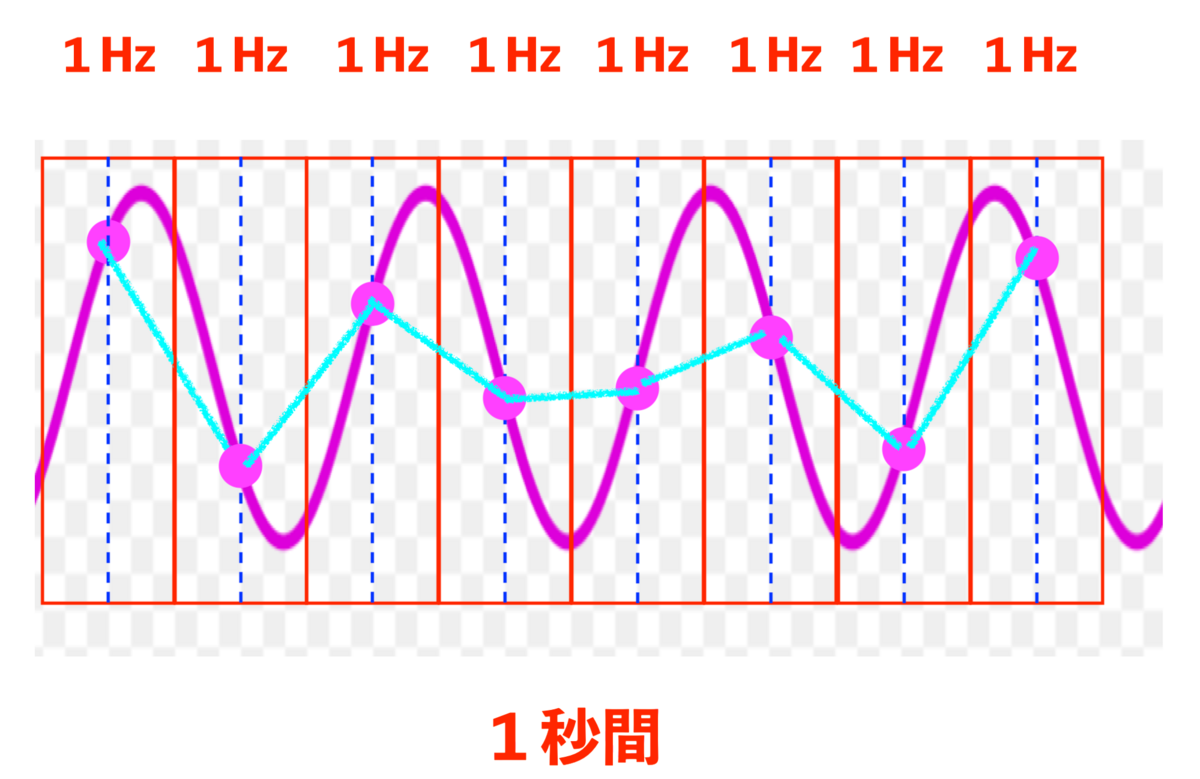

1秒間にこんな振動があったとして、これを四回/4Hz標本化した点データをつなげてもただの直線です。このピンクの丸には、音の高さ、大きさ、長さなどのデータが詰まっています。

その倍の周波数でサンプリングしました。だいぶ波形っぽくなりましたが、まだ再現できているとは言い難いです(実際これをオーディオ化すると点と点の間は少しカーブを描く=トゥルーピーク)。再生するとそれっぽい音がしますが、ちゃんと再現できていない点がノイズになったり水中のような感じとか、カクカクとした音になります。まだサンプリングが甘い。さらに細かく標本化します。

いよいよ波形っぽくなりました。

サンプリング周波数は細かければ細かいほど正確に現実を再現できるわけです。

細かすぎると今度はストレージを圧迫します。通例CDの1曲5分は44.1KHz/16bitで大きくても60MBくらいですが、これが192Hz/24bitになると350MBぐらいになります。3曲で1GBってどんな楽曲??ってなります。あんまり容量が大きいデータでの処理は疎まれます。だから現実的にサンプリングは程よい容量が好まれています。

そうでなくても一般にはmp3なら4MBとかで十分聴けると感じていると思います。

ある波形を正しく標本化するには、波形の持つ周波数成分の帯域幅の2倍より高い周波数で標本化する必要がある(これをサンプリング定理と呼ぶ)。

理論上はサンプルレートの二倍以上の周波数が必要です。

2000Hzの音は1秒間に2000回振動してます。それぞれの波にチェックを入れるだけでも1秒間を2000回に区切る必要があります。しかしそれだけでは最初に図で示した通り、十分な波形として再現できません。状況によってはただの直線信号になってしまうことも。

十分な形の波形を再現するためにはその音の倍、ここでは4000回以上のサンプリングを行うことを基本にしてよりしっかりした標本化データに落とし込むことが可能になる、という理論がサンプリング定理です。

4000Hzというサンプリング周波数で正しく再現できるのは2000Hz以下の信号です。

このサンプリング周波数の1/2の周波数をナイキスト周波数と呼びます。サンプリングできる目安の周波数ですね。ナイキが好きな人ではありません。情報理論の先生の名前です。

CDは44.1KHzですが、この値で20.05KHz以下の音がより正確に標本化されます。

20.05Khzは20050Hzです。人間が聞き取れるには20000Hz以下ですから、44.1Khzのサンプリングを行えれば、十分に音楽的な情報はサンプリングできる計算になります。

それを48KHzとか96KHz、先に触れた192KHzなどでサンプリングしたら、それはいい音で再現できるはずです。1秒間を192000回に区切るのですから、1/1000秒を192回区切っています。CDの音質は1/1000秒を44.1回区切ってます。人間がどこまで知覚できるか、という限界もありますから、そんなに音質だけをあげていかなくても「音楽の情報の概略」を正確に捉えることができます。

さらに横に区切るのが量子化ビット/ビット深度です。「量子」なんて量子力学的な感じなの?難しい!!と思うかもしれませんが、量子とはもともと「定まった量についての概念」のことで、量子力学とは関係ありません。

量子化とは定まった値にすること、です。

だから量子化ビットとは、ビット数で定まった値にして計算する、というだけの意味です。

ここでは24ビ...テガーになってます、が

24ビットインテガー=24bit整数という意味で、後で説明しますが、これが横の量子化ビット数です。

24段階に分ける?かというと違います。2の24乗段階に分けます。

16777216段階に分けて横線を書く、わけです。

16bit(2の16乗)を24bit環境で作ると解像度は256倍になります。

数が大きくなればサンプリングする方眼紙のマスの細かさにつながります。

こちらも細かければ細かいほど、音データを楽曲制作のサンプルとして使う時、テンポやキーを変えた時などに変なエラーやカクカク感(データいじった感)が表面化してしまうことを極力防げます。

またやはりこれらの分解能が大きければ大きいほどCPUにも負担になります。

<バッファ>

簡単な一桁の暗算クイズに答える余裕が3秒しかないより、10秒あった方が計算は楽です。これをバッファと言います。「緩衝」と訳されたりします。

上の図でいう512がバッファになります。ここを小さくすると計算の余裕時間が少なく、人であれば回答を投げ出し、PCならば固まったり、エラーが出たりします。逆にあまり大きいと余裕がある分、遅延が生じて挙動にストレスを感じることがあります。

このタイミングでストップ!と思ってenterを押しても反応までにしばらくかかるので

きちんとしたタイミングで止まってくれなかったりするわけです。

自分が扱っているデータと、作業しながら感じる違和感のストレスがなくなるちょうどいいところを探して設定してください。

ナイキスト周波数

先にちょっと触れましたね。

サンプリングの点が少なすぎると、結ぶ点が別の周波数の波を作り上げてしまい、それを音として認識されて振動として検知され実際の音/ノイズになって耳に届いてしまいます。これをエイリアシング(エラー)、折り返し雑音などと言います。下記動画でエイリアシングが蠢いているのがわかります。-30dBFSより小さな音ですから、なかなか耳で捉えるのは大変ですが、確かに存在しています。

人間の目でも似たような現象が起きています。前に少し話しましたがヘリコプターの翼の回転がゆっくりに見えたり、逆回転に見えたりするあの現象です。回転翼のスピードが人間の目のサンプリング周波数に追いつかないためです。人間の目は性能が良くて20Hz/sということです。

そして逆にこの性能を利用して、信号は本当は点滅しているのに点灯して見えたり、コマ送りされている写真を動画のように見たりします。

LED信号機とかは目には点灯しているように見えますが、録画のサンプリング周波数よりは荒いので点滅して録画されたり、全く映らない時もあります。

これも先に描いた「二倍の周波数がサンプル化には必要」という話に関わっています。

まずは利用周波数に対してサンプリングが二倍以下でないとこうしたノイズが乗ってしまう可能性がある、ということだけ理解すれば十分です。

またコンバータによっては、サンプリング周波数周辺の高い音域だと折り返し雑音が発生しやすい特徴、ということも含め、こうした「認識ミスによる誤った周波数が発生する可能性のある高い音域」を除去するためにローパスフィルタ、つまりハイカットすることでエイリアシングが生まれるのを防ぐ(アンチエイリアシングフィルタ)という手立てを取ります。

なお「折り返し」は、周波数とサンプリング周波数の関係で、ノイズが発生する周波数が、ある点を境に線対称の関係になるために、「ある周波数の点から折り返したとき一致した点に存在する周波数が折り返し雑音の周波数になる」的に覚えておいてください。

200Hzがナイキスト周波数の時、100Hz | 300Hzとか真ん中の200Hz(|線)で折り返すと線対称ですよね。ナイキスト周波数を中心に折り返しの関係に対応する周波数がノイズになりやすい、的な観察に基づいた命名なのだそうです。

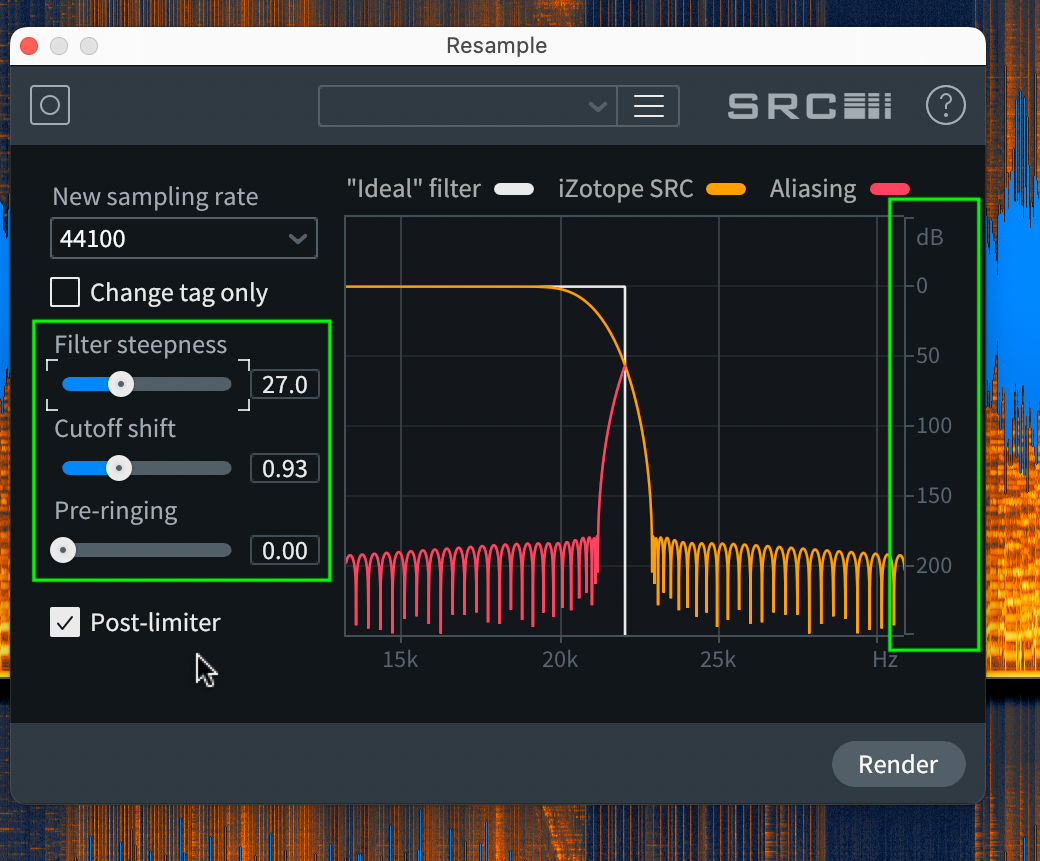

RXでResampleが可能、という動画は前回示しました。

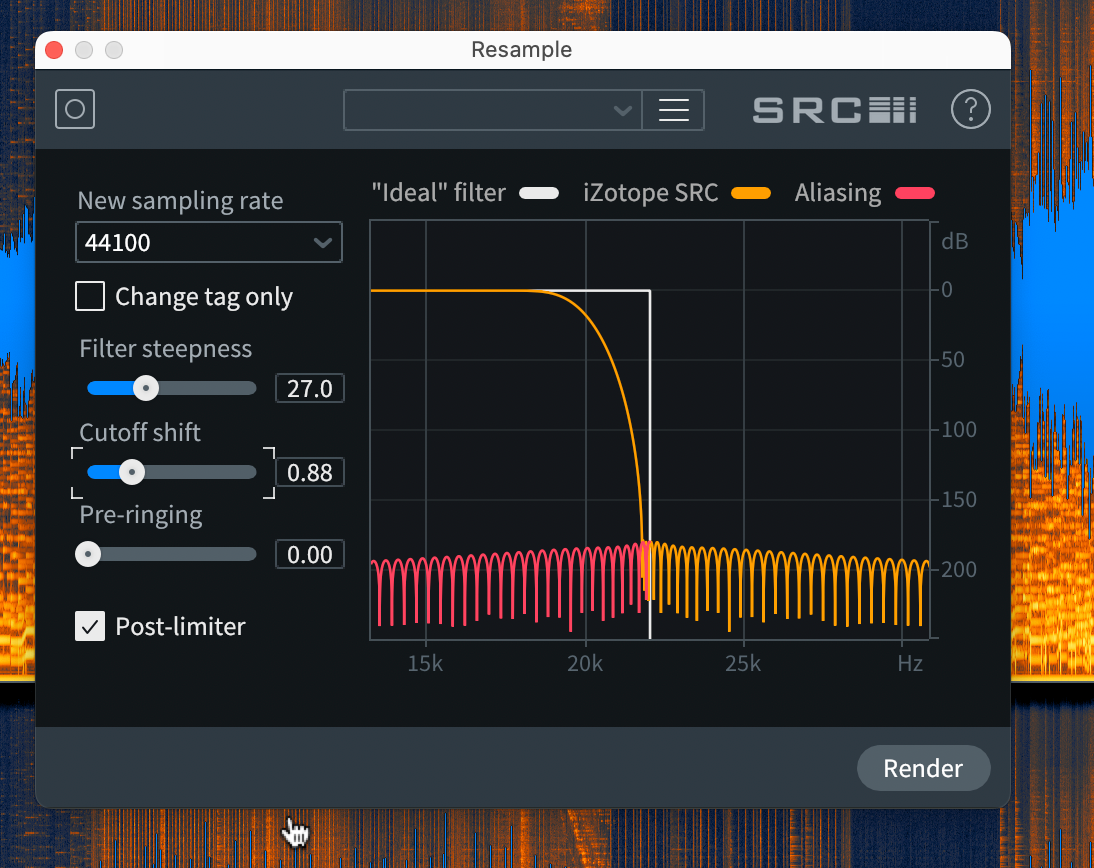

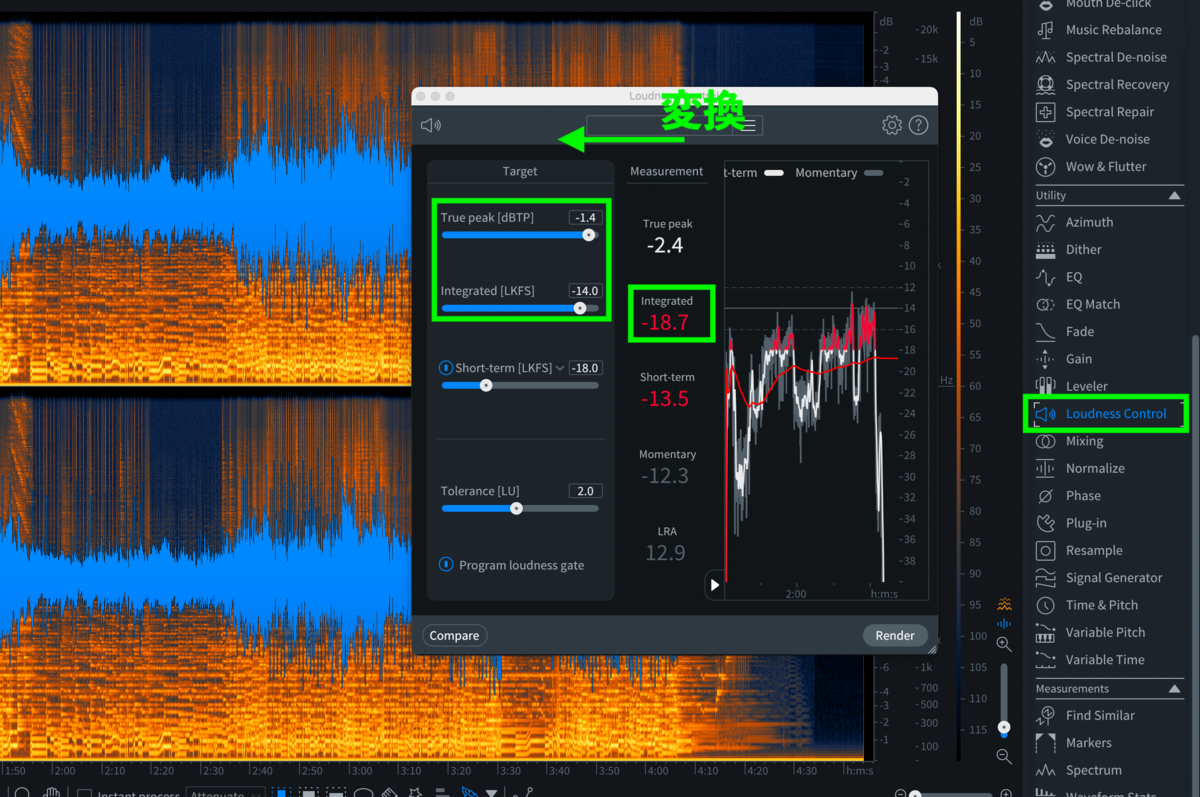

これは48000を44100にダウンする時の設定画面です。

白い線がナイキスト周波数です。つまり44100の半分、22050Hzの線です。ここを折り返すようにノイズが発生します。SRCとはSample Rate Conversion=サンプルレート変換の意味です。

上の図ですと、-2.5dBの強さでノイズが22.5kHz以下たりから生まれますよ、ってことです。-5dbって結構な大きさですね。普通にフェーダーで表現できる世界です。しかし20Kh以上の音ですから、人間は聞けません。

ただこのサンプルをDJが1/4のスピードに落としたらどうでしょう。その時ピッチも下がりますね。仮に20KHzが1/4の5Khzのノイズになったらどうでしょう。

5000Hzですから十分チーーーーーって聞こえるかもしれません。

DJがダウンスピードした時のことを考えるわけではありませんが、できる限りいろんな状況でノイズが表面化しないように考えたい人は考えてください、的な感じです。マスタリングの先生方に怒られるかもしれませんが、結構マニアな話ですし、通例再生する分には聞こえない話です。音楽理論に例えると、ヴォイシングを細部までしっかり気にしろ、みたいな話です。

ジョナサン・ワイナー氏は、ヘビーメタルだったら必要ないかもしれないが、ハイファイのクラシック音楽だとこのエイリアシングが命取りになる、的なことを言っています。

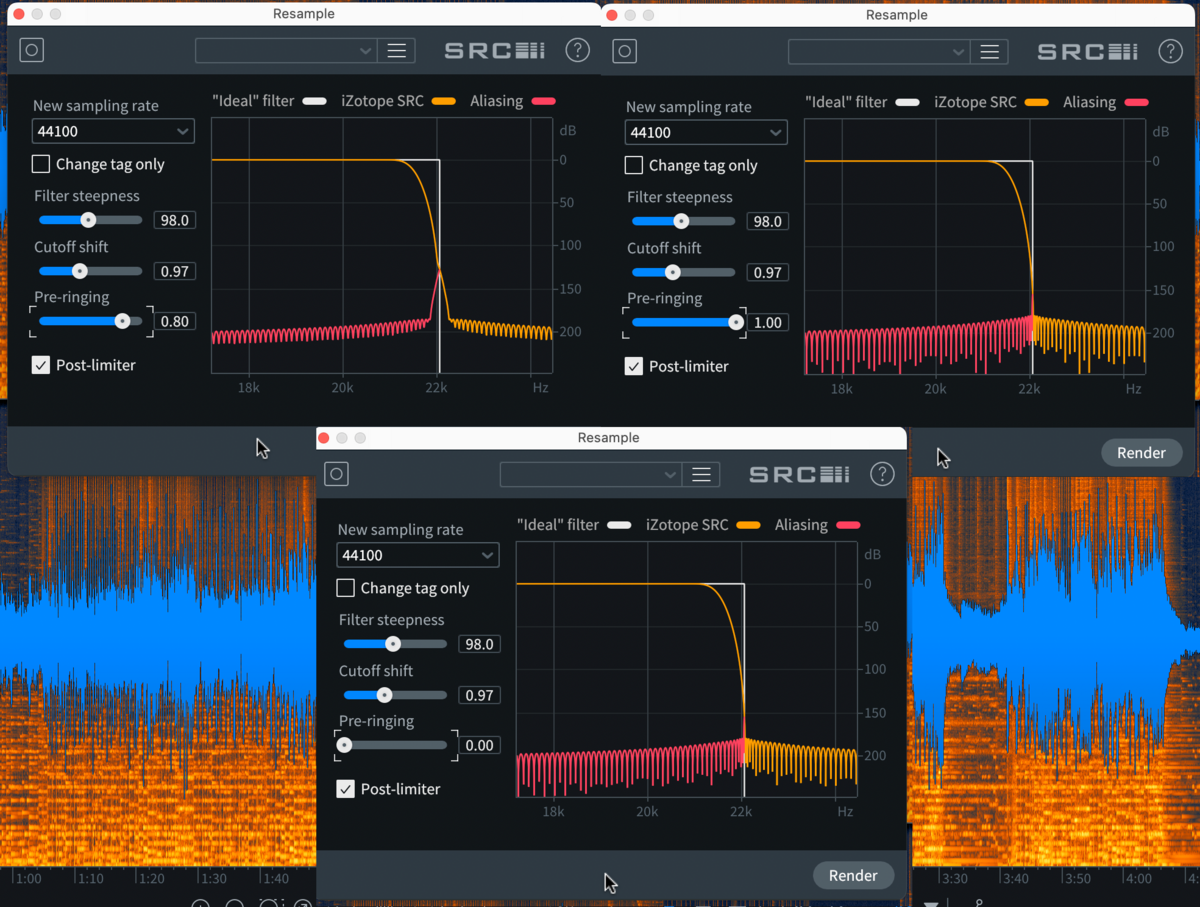

作業としては、右の目盛の上でスクロールしながらノイズの全貌を表示し、左の三つの値を決めてゆきます。この感じだと、まだ-50dBあたりにノイズがあります。この辺りでもほとんど聞こえませんが、せっかくですからいろんな値を見てみましょう。

これはどうでしょう。ノイズは-200db以下になっていますので、耳がつんざく以上の音量で聞かないともうこれらのノイズは聞こえません。でもカットのカーブの始まりが20kHzをきっています。これだと人の耳が聞こえる20KHzを少し被っていますから、聞かせたい高音域をカットしていることにもなります。ちょっとカーブが緩すぎるんですかね。

これはどうでしょう。ギリギリ20KHz以上からカットを始めエイリアシングが表面化しないギリギリところで設定しています。

なおPre-ringingはジョナサン・ワイナー氏がマスタリング講座の中で1/4ほど右に戻す、と言っていたのを採用して現在0.75という値にしてます。

私は専門家ではないので、経験が足りません。

Pre-ringingの設定ではそれぞれに興味深いカーブになります。

どれが自分にとって良い音か研究していただきたいです。

Pre-rigingという用語自体は、リニアフェーズEQなどで知られていますが、EQをかけた時、その電圧値の変動がノイズになって、音の発生時前の吸い込みノイズのような「発音前に鳴ってしまう音」が生まれる現象です。音が鳴る前にノイズが入るのですから、トランジェント、つまりアタック感をこもらせたり、歪ませたりしてしまうことになります(状況によっては柔らかくなったと感じたり、暖かくなったと感じることも)。

できる限り正確に音を処理したいなら、このプリリンギング、その後に残るポストリンギングの影響は最小限がいいに越したことはないのですが、なにぶん耳に聞こえない成分であることが多いので、なかなか職人さんでないと使い分けが難しいです。

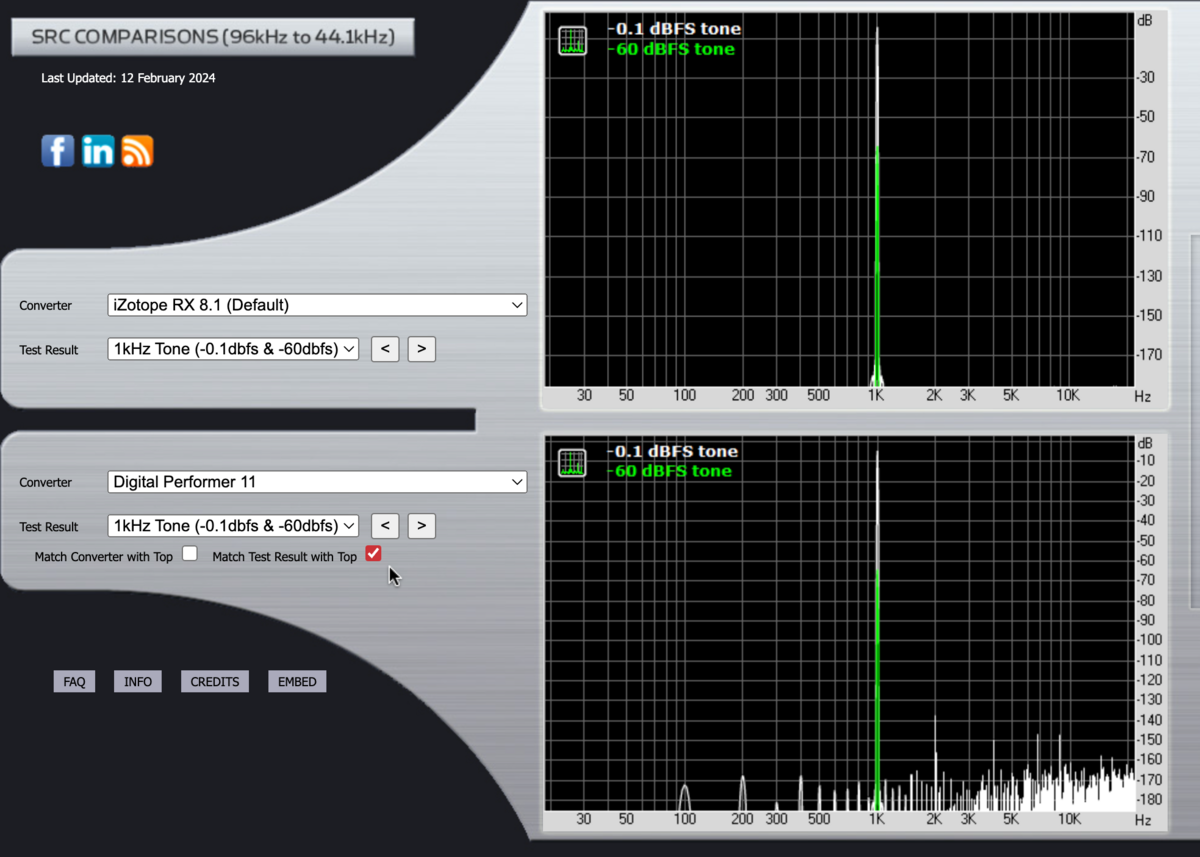

なお、こちらのサイトで(RXヘルプやジョナサン・ワイナー氏の講義で紹介があった)各コンバーターでのエイリアシングのデータがまとめてみられます。

DP11とRX8を比較してみましょう。

96KHzのデータを44.1KHzに変換した時のシミュレーションです。

若干DPの方にノイズが入っているのがわかります。これは少ない方です。

古いDP5だとこんな感じですから、11が進化していることも把握できます。

他のDAWも確認できます。今をときめくDAWはみんな性能が高いです。

1KHz音を変換した時のノイズです。-140dBあたりですからほとんど聞こえませんが、RXはほとんど出ませんね。今示したカーブの自在設定のためでしょうか。

フィルターカーブ。DPは20KHzを割ってカーヴが始まっています。

こういう点から、DPではそのまま書き出して、RXでリサンプリングする、という選択肢が見えてくるわけですね。

インパルスのプリリンギングはDPの方が優秀??専門家ではないので言及は避けます。

32bit float

ついでにこれは今回はあまり関係がないですが、現DPは基本的に32bit floatで処理を行なっていますので、何も考えなくても事故の少ない音声データが取り扱えるようになっています。

Windows32bit、64bit対応、とかの32bitはWindowsというOSマシンが一度に行う計算容量のことですから、昔の携帯で動画がカクカク動いていたのがどこにいてもスムーズに動画が見れる的な処理速度の関係なので、DAWの作業におけるビットレートとは関係ありません。ややこしいですね。

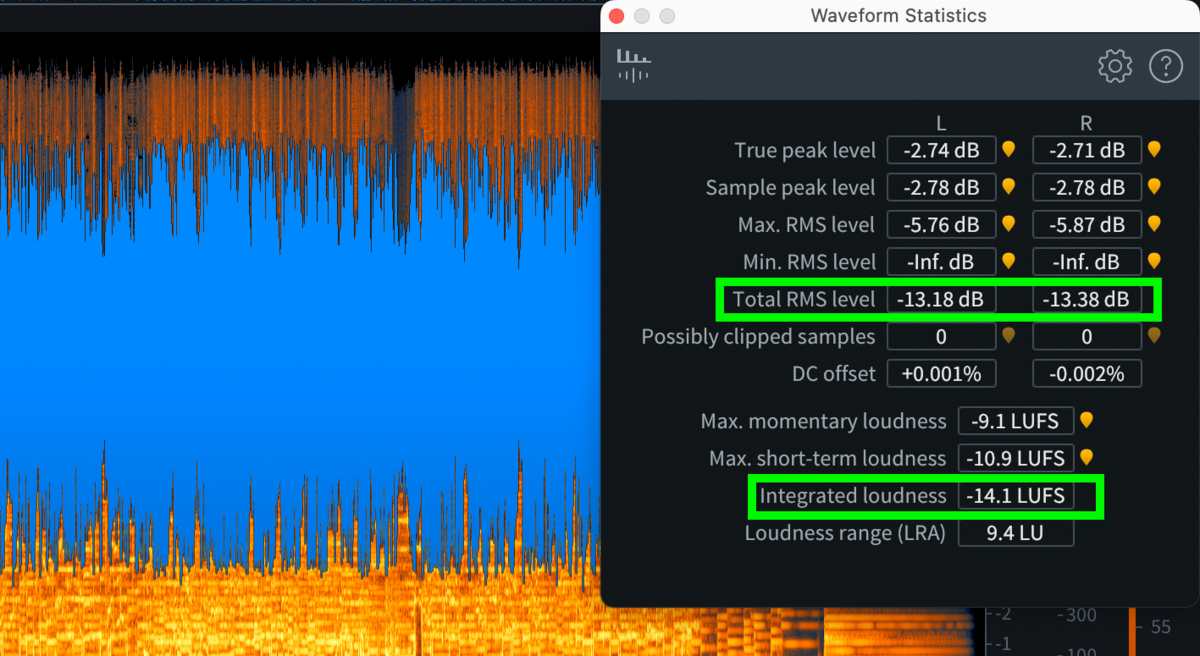

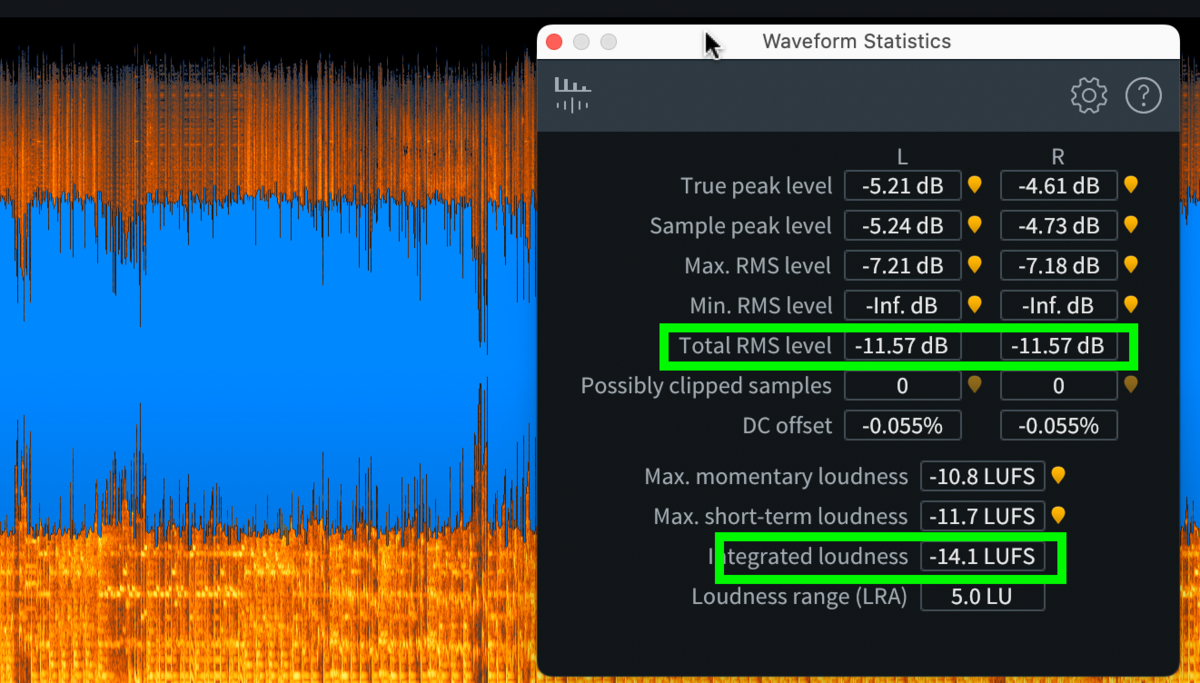

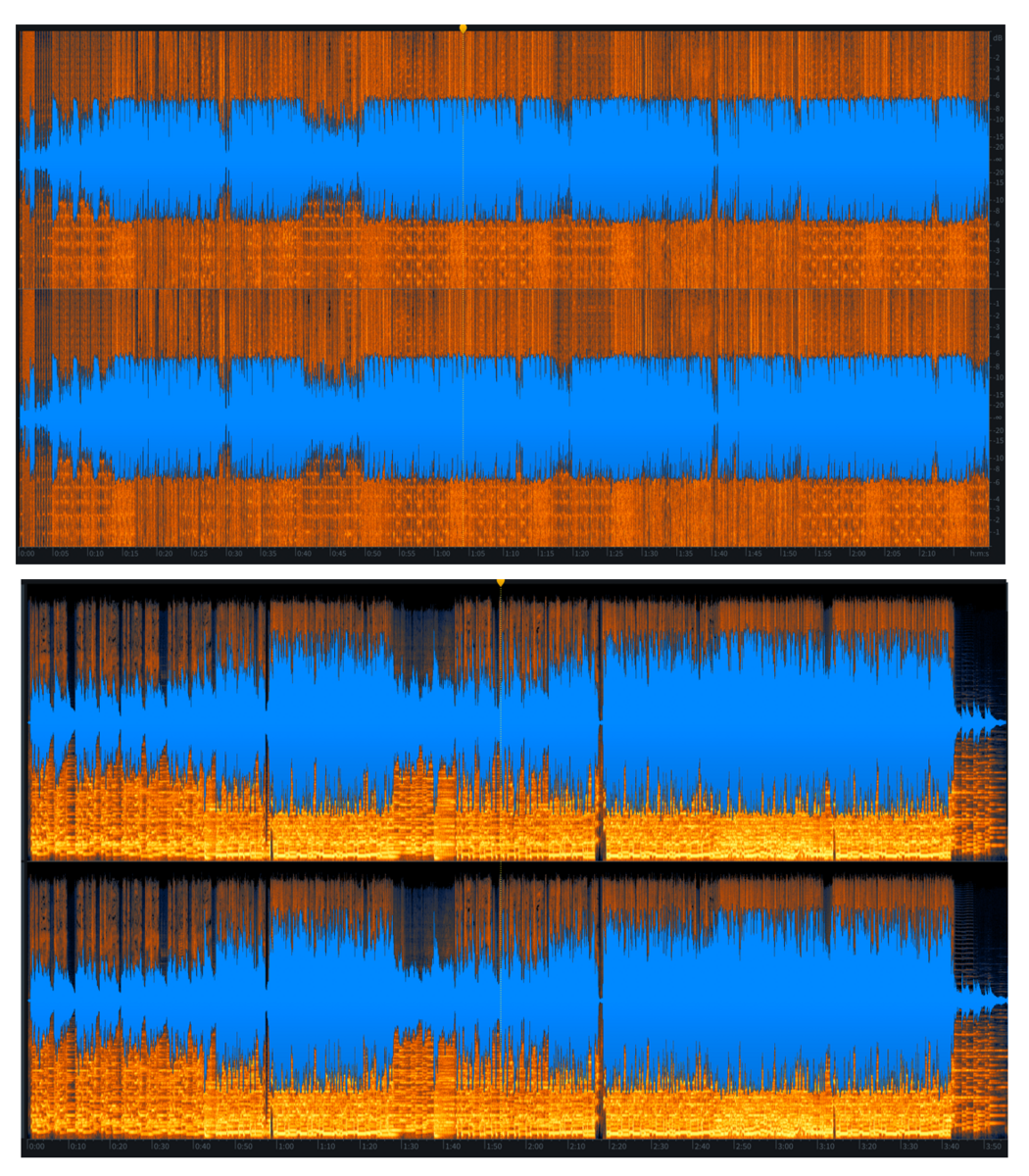

この二つの音楽データ、spotifyではどちらも同じ-14.1LUFSでアップされています。

しかしトータルのRMSレベルは波形に応じて幅が狭い方が-11、幅が大きい方が-13とこちらの方が計算上は小さいと計算されています。

しかし時際に聞いてみるとやはり波形が大きい方が大きく聞こえます。

上の波形

下の波形

ダイアミクスレンジが上の波形の方が広いです。ゆえに、上の波形の方が大きく聞こえる感じを得る時があります。相対的なものかもしれません。

音圧戦争の頃は下の波形などが画面いっぱいに広がったものですが、ストリーミングサービスのサービスが向上した結果、

こんなふうに青い線の位置まで押さえ込まれてしまうんです。激しい曲も静かな曲も大体おんなじ音量で聴けるようにしてくれるんですね。

逆にダイナミクスレンジがあった(=大きなクレストファクター)ほうが、全体の波形位置が大きくなる、という点もストリーミング時代ならではです。

理想は下記のようなハリセンボン波形でミックスすべき時代が来た、ということです。

ノリ波形の時代が終わりウニ波形の時代です(全ての曲においてこれがベスト、という意味ではなく、少なくともノリ寄りよりもウニ寄り、がより現実的かも、という程度の意味です)。海苔とかウニとか抽象的なので だいたいで解釈してください。

またRXがあれば、データを開いて、Loudness controlでTargetのLKFS(LUFSと同じ意味)値を設置して「Render」するとSpotify用のデータはすぐ作れます。

もちろん音質の変化は起こり得るので、ミックス/マスタリングができるなら、可能な限り前作業で揃えることをお勧めします。

ラウドネス各値についての確認は下記にて。

この辺はいよいよデジタルデータを取り扱う専門知識になるので、追って調べて加筆いたします。

エクセルの高速フーリエ変換計算を用いて、エイリアシングとEQ作業を体験

こういう動画で簡単に学べます。

100Hzと10Hzの波形から高速フーリエ変換によって、周波数の表にします。

サンプリングは1024Hzです。つまり一秒を1024分割していきます。

ずらっと自動計算でできます。

ずらっと自動計算でできます。

ここの与えるサイン波の数式だけ教えていただいて、あとは

エクセルに実装されている"フーリエ解析"関連ツールを使うだけです。

フーリエ変換すると、見事に10Hzと100Hzに周波数が出ているイコライジングが見られます。

するとサンプリング周波数の1/2である500Hzを折り返し点として、900Hと990Hzのところに同じような波形が生まれます。サンプリング行為によって生まれてしまうエイリアシングですね。波線に点を打っていく作業では同じ波形になってしまう点が数学的に生まれるからですね。

手作業EQ

おまけですが、この900Hzあたりの値を0にしてあげると、

こんなふうにカットできます。EQのカット作業と同じです。

ちょっと中途半端ですが。

我々ものぐさなDTMer的にはこういうことはEQが、メータープラグインが自動的にスペクトル分析とか、周波数分析とか示してくれるのであんまり感動がないんですが、これらも全て人が考えた手計算から成り立っている、ということを実感できます。

気がつかないうちに毎日使っている高速フーリエ変換。

スペクトル画面見れているから、DTMerは全員フーリエ変換が計算できる、というわけではない、っていうのは、携帯電話の販売員だから全員電磁波のこと詳しいわけではない、みたいなことに似ています。

高校まで行って微分積分やった経験があって、いま暇な人は勉強して詳しくなっておいても良いのではないでしょうか。

次は0zone12の新機能/公式情報まとめページです。